低VRAMでも動く!AI動画生成ツール「Wan2GP」完全ガイド:インストールから使い方、応用テクニックまで徹底解説のPodcast

下記のPodcastは、Geminiで作成しました。

はじめに:AI動画生成を、もっと身近に

近年、テキストや画像から高品質な動画を生成するAI技術は目覚ましい進化を遂げています。しかし、その最先端技術を試すには、数十万円もする高性能なグラフィックボード(GPU)が必要となるケースが多く、多くのクリエイターにとって大きな障壁となっていました。「AIで動画を作ってみたいけれど、高価なPCがないから諦めている」——そんな悩みを解決するために登場したのが、今回ご紹介する「Wan2GP」です。

Wan2GPは、その名の通り「GPU Poor(GPUに恵まれない人々)のためのWan 2.1」というコンセプトを掲げた画期的なツールです。このプロジェクトは単なる一つのソフトウェアに留まりません。開発者である

deepbeepmeep氏は、動画生成だけでなく、3Dモデル生成(Hunyuan3D-2GP)、音楽生成(YuEGP)、画像修復(FluxFillGP)など、様々な分野の最先端AIを低スペックPCで動作させるための一大エコシステムを構築しています 3。このエコシステムの根幹には、

mmgp(Memory Management for the GPU Poor)という独自のメモリ管理技術が存在し、一貫した思想のもとに開発が進められています 3。Wan2GPを学ぶことは、この「AIの民主化」という大きな潮流への入り口を意味し、クリエイティブ活動の可能性を大きく広げる第一歩となるでしょう。

Wan2GPとは? - 低スペックPCの救世主

Wan2GPは、中国の巨大IT企業アリババが開発した高性能な動画生成AI「Wan 2.1」をベースに、deepbeepmeep氏が徹底的な最適化を施したオープンソースのソフトウェアです 。2025年3月頃に公開されて以来、その画期的な性能から世界中の注目を集めています 7。

その最大の特徴は、オリジナルのモデルが要求する膨大なVRAM(ビデオメモリ)を劇的に削減し、一般的なゲーミングPCやクリエイター向けPCでも快適に動作するように設計されている点です。これにより、これまで一部の専門家や研究者に限られていた高品質なAI動画生成が、より多くの人々の手に届くようになりました。

なぜWan2GPは画期的なのか?- 主な特徴とメリット

Wan2GPが多くのユーザーから支持される理由は、単に低スペックで動くだけではありません。ここでは、その画期的な特徴とメリットを3つのポイントに分けて解説します。

圧倒的な低VRAM要件

Wan2GPの最も特筆すべき点は、その驚異的な省メモリ性能です。例えば、テキストから動画を生成するT2V-1.3Bモデルは、わずか8.19GBのVRAMで動作します。これにより、12GB程度のVRAMを搭載した一般的なPCでも480p解像度の動画を生成でき、設定次第では5GBから6GBという極めて低いVRAM環境でも動作が可能です。これは、オリジナルモデルや他の最先端AIが要求する24GB、32GB、あるいは80GBといったVRAM量とは比較にならないほどの低さであり、まさに「GPU Poor」の救世主と呼ぶにふさわしい特徴です。

多彩な機能と高品質な出力

Wan2GPは、省メモリでありながら機能や品質に一切の妥協がありません。テキストから動画を生成する「Text-to-Video (T2V)」や、一枚の画像から動画を生成する「Image-to-Video (I2V)」はもちろん、既存の動画の編集や、中国語と英語のテキストを映像内に綺麗に描画する世界初の機能も搭載しています 。特にI2Vの性能はコミュニティで高く評価されており、元画像の画風やキャラクター性をほとんど崩さずに、滑らかなアニメーションを生成できると評判です 。

活発な開発と迅速なアップデート

Wan2GPのもう一つの魅力は、その開発スピードの速さです。GitHubのリポジトリを見ると、2025年5月から6月にかけてv5.1からv6.0へと立て続けにアップデートが行われるなど、驚異的なペースで進化を続けています 1。この短期間に、わずか4〜12ステップで高速に動画を生成できる「CausVid」モデルや、より高度な動画制御を可能にする「Vace FusioniX」、音声に合わせて口パク動画を生成する「Hunyuan Video Avatar」など、次々と新機能が追加されています。

この驚異的な開発速度の背景には、開発者と活発なユーザーコミュニティとの間に築かれた強固な協力関係があります。GitHubのIssueページには常に数百件の要望やバグ報告が寄せられ、ユーザーは巨大なテストチームとして機能しています。開発者はこのフィードバックに迅速に応えるだけでなく、コミュニティメンバーによるコードの貢献(タスクのキュー管理システムなど)を積極的に取り入れたり、プロンプトの指示精度を向上させる学術研究(CFG-Zero-star)をコミュニティの要望に応じて実装したりしています 2。この「アクセシビリティがユーザーを呼び、ユーザーがフィードバックで開発を加速させ、進化したツールがさらに多くのユーザーを惹きつける」という好循環こそが、Wan2GPが常に最先端を走り続ける原動力なのです。ユーザーにとって、これは単なるソフトウェアのダウンロードではなく、進化し続けるプロジェクトへの参加を意味します。

導入前の基礎知識 - AI動画生成の必須用語をやさしく解説

Wan2GPを使い始める前に、いくつか専門用語を知っておくと、よりスムーズに理解が進みます。ここでは、AI動画生成で頻繁に登場する必須用語を、初心者にも分かりやすく解説します。

VRAM (ビデオメモリ)

VRAMは「GPU専用の高速な作業台」と考えると分かりやすいでしょう。GPUが画像や映像の処理を行う際に、必要なデータ(テクスチャ、モデル情報など)を一時的に置いておくための専用メモリです。この作業台が広ければ広いほど(VRAM容量が大きいほど)、高解像度で複雑なプロジェクトでも、データを頻繁に入れ替える必要がなくなり、処理がスムーズに進みます 。Wan2GPが画期的なのは、この作業台を非常に効率的に使う技術によって、小さな作業台でも大きな仕事ができるようにした点にあります。

Gradio (グラディオ)

Gradioは「AIモデルのための、インスタントなWeb操作画面(UI)作成ツール」です 。通常、AIモデルを操作するには専門的なプログラムコード(命令文)を書く必要がありますが、Gradioを使うと、開発者は数行のコードでスライダーやボタンを備えた直感的なWebページを簡単に作成できます 。Wan2GPの使いやすい操作画面は、このGradioという技術によって作られています 。

LoRA (ローラ)

LoRAは「AIモデル用の、軽量な『画風パッチ』や『キャラデータ』」のようなものです。巨大なAIモデル全体を再学習させるには膨大な時間とコストがかかりますが、LoRAは「特定のキャラクター」や「特定のアニメ風の画風」といった追加情報だけを学習させた小さなファイルです 。このパッチを適用することで、元のモデルの能力を活かしつつ、手軽に生成結果をカスタマイズできます 。

ControlNet (コントロールネット)

ControlNetは「AIに対する、精密な『設計図』」の役割を果たします 。テキストのプロンプト(指示文)だけでは難しい、キャラクターの正確なポーズや、物の配置(構図)、奥行きといった情報を、参照画像(設計図)を使ってAIに細かく指示するための技術です。これにより、ユーザーは偶然の産物に頼るのではなく、まるで映画監督のように、意図した通りのシーンを生成できます。Wan2GPに搭載されている「VACE」は、このControlNetを動画生成に特化させた強力な機能です。

Finetuning (ファインチューニング)

ファインチューニングは「汎用的なAIに、専門分野の『博士号』を取らせる」プロセスです 。既に幅広い知識を持つ学習済みモデルに対して、特定の専門分野(例えば、医療、法律、あるいは特定の作風など)のデータを追加で学習させることで、その分野に特化した専門家AIへと性能を向上させる手法です。

Wan2GPのインストール方法

Wan2GPは、ユーザーのスキルレベルに合わせて複数のインストール方法が用意されています。これは、セットアップの技術的なハードルを可能な限り下げ、誰もがすぐにクリエイティブな作業に取り掛かれるようにという開発者の配慮の表れです。初心者の方は、最も簡単な「Pinokio編」から試すことを強くお勧めします。

簡単インストール (Pinokio編) - 1クリックで始めよう

Pinokioは、様々なAIアプリケーションを簡単な操作でインストール・管理できるデスクトップアプリです。Wan2GPは公式にPinokioをサポートしており、これを利用するのが最も簡単で確実な方法です 。

- Pinokioの公式サイトから、お使いのOS(Windows/Mac/Linux)に合ったアプリをダウンロードしてインストールします。

- Pinokioを起動し、「Discover」ページで「Wan2GP」を検索します。

- 「Download」ボタンをクリックし、表示される指示に従ってインストールを進めます。

これだけで、必要なファイルのダウンロードから環境構築までが自動的に完了します。

手動インストール (Conda/Pip編) - ステップ・バイ・ステップ解説

より詳細な設定を行いたい方や、既存のPython環境を活用したい方向けに、手動でのインストール方法も提供されています。以下の手順に従ってインストールしてください。

- リポジトリのクローン:Bash

git clone https://github.com/deepbeepmeep/Wan2GP.git - ディレクトリの移動:Bash

cd Wan2GP - Conda環境の作成と有効化:Bash

conda create -n wan2gp python=3.10.9 conda activate wan2gp - PyTorchのインストール:Bash

pip install torch==2.6.0 torchvision torchaudio --index-url https://download.pytorch.org/whl/test/cu124 - 依存関係のインストール:Bash

pip install -r requirements.txt

なお、リポジトリにはNVIDIAのRTX 10XXシリーズから将来の50XXシリーズまで、各世代のGPUに合わせたより詳細なインストールガイドも用意されており、長期的なサポート体制が整っています。

パフォーマンスプロファイルの選択

Wan2GPには、お使いのPCのスペックに合わせてパフォーマンスを最適化するためのプロファイルが用意されています。アプリケーションを起動する際に、これらのプロファイルを選択することで、リソースの使用率を調整できます。

| プロファイル名 | VRAM/RAM要件 | 速度 | ユースケース |

LowRAM_HighVRAM | 高VRAM, 低RAM | やや高速 | VRAMに余裕があり、少しでも速度を優先したい場合。 |

LowRAM_LowVRAM | 低VRAM, 低RAM | やや低速 | VRAMとRAMの両方を節約する必要がある、最も省メモリな構成。 |

基本的な使い方 - Gradio UIで動画を生成する

インストールが完了したら、いよいよ動画を生成してみましょう。Wan2GPは直感的なGradioのUIを採用しているため、専門知識がなくても簡単に操作できます。

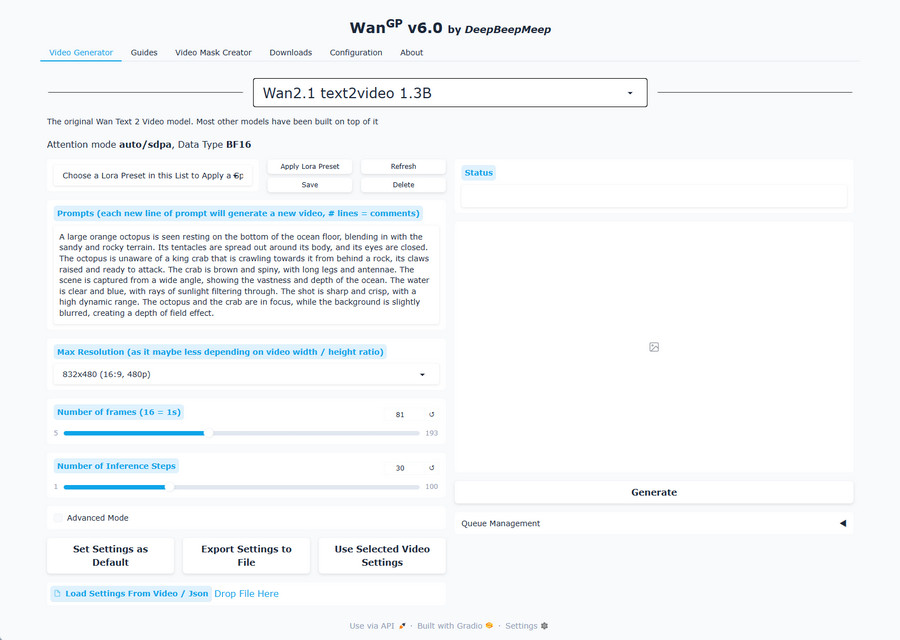

アプリケーションの起動とUIの概要

Wan2GPアプリケーションをクローンしたディレクトリ内で実行する必要があります。例えば、DドライブのルートディレクトリーにWan2GPをインストールした場合は、PowerShellなどを使い次の手順で進めます。

- 正しいディレクトリに移動

cd D:\Wan2GP - conda環境をアクティベート

conda activate wan2gp - アプリケーションを起動

python wgp.py起動までに時間がかかりますので、気長に待ちましょう。

「* Running on local URL: http://localhost:7860」と表示されたら、Ctrl +「http://localhost:7860」をクリックして下い。すると、ブラウザーの別タブに「Wan2.1」が立ち上がります。

画面上部には、使用するAIモデルを選択するドロップダウンメニューがあります。ここから「Text-to-Video」や「Image-to-Video」など、目的に合ったモデルを選びます。また、生成タスクを次々と予約できるキューイングシステムや、生成した動画の設定をJSONファイルとして保存・読み込みする機能、さらには動画ファイルをドラッグ&ドロップするだけで設定を復元できる便利な機能も搭載されています。

Text-to-Video (T2V)

テキストから動画を生成する最も基本的な使い方です。

- モデル選択でT2Vモデル(例:

wan2.1_t2v_1.3B)を選びます。 - 「Prompt」というテキストボックスに、生成したい動画の内容を英語で入力します。

入力したプロンプト:The video shows a lion sprinting across the vast African grasslands. Sunlight shines on its smooth golden mane, and its powerful, muscular body moves with every stride, displaying incredible strength and speed. The background is an endless savanna, dotted with a few solitary trees in the distance. The sky is blue with drifting clouds, creating a spectacular natural scene. Every leap and turn of the lion is full of wild charm, making you feel the raw vitality of nature. - フレーム数(

Number of frames)やステップ数(Steps)などのパラメータを調整します。 - 「Generate」ボタンをクリックすると、生成が開始されます。

下記が生成された動画です。

Image-to-Video (I2V)

一枚の画像から動画を生成する、Wan2GPの得意な機能です。

- モデル選択でWan2.1 image2video 480p 14Bモデルを選びます。

- 画像アップロードエリアに、動かしたいキャラクターや風景の画像をドラッグ&ドロップします。

- 「Prompt」に、どのように動かしたいかの指示を入力します。

入力したプロンプト:A mystical video inspired by the uploaded image. A person is typing on a keyboard, and as they type, various objects, symbols, and shapes begin to emerge from the keyboard like swirling, ethereal smoke. The smoke is luminous and ever-changing, forming mysterious and magical patterns in the air. The scene is filled with a sense of wonder and creativity, with the background softly blurred to keep the focus on the hands, keyboard, and the enchanting smoke. The overall atmosphere is dreamy and otherworldly, blending reality with fantasy. - 「Generate」ボタンをクリックすると、アップロードした画像の雰囲気を保ったまま、滑らかな動画が生成されます。

下記が生成された動画です。

応用編:Wan2GPを使いこなす高度な機能

基本的な使い方に慣れたら、さらに表現の幅を広げるための応用機能に挑戦してみましょう。Wan2GPは、初心者がステップアップしながら習熟していけるように、機能が巧みに階層化されています。

LoRAで表現をカスタマイズする

LoRAを使えば、特定の画風やキャラクターを手軽に動画に反映させることができます。Wan2GPではLoRAの利用が非常に簡単になっており、30種類以上のLoRAパックをワンクリックでダウンロードできる機能や、プロンプト入力を補助するプリセット機能が用意されています 。これにより、複雑なプロンプトを毎回入力する手間なく、多彩な表現を試すことが可能です。

VACE ControlNetで動画を精密に制御する

VACEは、動画生成における「監督」の役割を担う、極めて強力なControlNet機能です。プロンプトだけでは制御しきれない、より詳細な演出を可能にします。動画の一部分だけを修正する「インペインティング」や、キャラクターの動きを別の動画から持ってくる「モーショントランスファー」など、多彩な機能が統合されています。

| 機能 | 目的 | 必要な入力 |

| 人物・物体の注入 | テキストで記述したシーンに特定の人物や物体を挿入する | 参照画像 + テキストプロンプト |

| キャラクターのアニメ化 | テキストで記述したキャラクターを動画の動きでアニメーションさせる | 人物が動く動画 + テキストプロンプト |

| モーショントランスファー | 参照画像のキャラクターに、別の動画の動きを忠実に適用する | 参照画像 + 人物が動く動画 + テキストプロンプト |

| スタイル・深度転写 | ある動画のスタイルや深度(奥行き)情報を別の動画に適用する | スタイル元となる動画 + テキストプロンプト |

| インペインティング/アウトペインティング | 動画の一部分を描き変えたり、映像の外側を描き足したりする | マスク画像 + テキストプロンプト |

この表は、あなたの創造的なアイデアを実現するための「レシピ本」として機能します。例えば、「自分のキャラクターにこのダンスを踊らせたい」と思ったら、「モーショントランスファー」の機能を選び、必要な材料(キャラクターの参照画像とダンスの動画)を揃えればよい、ということが一目で分かります。

ファインチューンで新しいモデルを追加する

Wan2GPのカスタマイズ性の頂点にあるのが、この機能です。コミュニティによって新しいAIモデルが公開された際に、ユーザー自身が簡単な定義ファイルを作成するだけで、そのモデルをWan2GPに統合できます。Wan2GPは、Hugging Faceのようなサイトから自動的にモデルをダウンロードし、使い慣れたインターフェースで最新のAI技術を試すことを可能にします。これは、Wan2GPが将来にわたって陳腐化することなく、常に進化し続けるプラットフォームであることを示しています。

まとめ

Wan2GPは、単なる「低スペックPCで動くAI動画生成ツール」ではありません。それは、アクセシビリティ(低VRAM要件)、パワー(多彩な機能と高品質)、そしてダイナミズム(活発なコミュニティと迅速な開発)という3つの要素を兼ね備えた、革新的なクリエイティブ・プラットフォームです。

最後に、これからWan2GPを始める方へ重要なアドバイスがあります。Wan2GPは、固定された一つの性能を持つツールではなく、様々な性能のモデルを動かすための「器(うつわ)」であると理解することが重要です。その「GPU Poor」という思想は、あくまで「低い参入障壁」を意味します。8GB程度のVRAMで始められる基本モデルもあれば、Hunyuan Avatarモデルのように10GBを要するもの、あるいは実験的な1080p生成モデルのように20GB以上のVRAMを要求するものまで、幅広い選択肢が用意されています 。

これは、Wan2GPがユーザーの成長と共に歩んでくれることを意味します。「今は手持ちの8GBのPCで基本を学び、将来16GBのPCにアップグレードしたら、同じ使い慣れたインターフェースで、より強力なモデルに挑戦する」といった、長期的な付き合い方が可能なのです。

AIによる映像表現の可能性は、もはや一部の専門家だけのものではありません。この記事をきっかけに、ぜひWan2GPをダウンロードし、公式Discordサーバー 1 に参加して、あなた自身のAI動画制作の旅を始めてみてください。

参考資料

- Hunyuan3D-2GP: 3D Generation for the GPU Poor, https://github.com/deepbeepmeep/Hunyuan3D-2GP/blob/main/README.md

- GitHub - deepbeepmeep/Wan2GP: Wan 2.1 for the GPU Poor, https://github.comcom/deepbeepmeep/Wan2GP

- GitHub - Decentralised-AI/Wan2GP: Wan 2.1 for the GPU Poor, https://github.com/Decentralised-AI/Wan2GP

- Milestones - Decentralised-AI/Wan2GP · GitHub, https://github.com/Decentralised-AI/Wan2GP/milestones

- Actions · Decentralised-AI/Wan2GP · GitHub, https://github.com/Decentralised-AI/Wan2GP/actions

- Wan2GP v2 : download and play on your PC with 30 Loras in just a few clicks. : r/StableDiffusion, https://www.reddit.com/r/StableDiffusion/comments/1jdqnaa/wan2gp_v2_download_and_play_on_your_pc_with_30/

- Issues · deepbeepmeep/Wan2GP · GitHub, https://github.com/deepbeepmeep/Wan2GP/issues

- Wan2.1 GP: Powerful Video Generation Model Optimized for Low-Spec GPUs, https://www.aibase.com/news/15923

- Hunyuan Video Avatar от Wan2GP (вроде как на 10 GB памяти запускается...), https://dtf.ru/id32166/3813117-hunyuan-video-avatar-ot-wan2gp-vrode-kak-na-10-gb-pamyati-zapuskaetsya

- DeepBeepMeep/Wan2.1 · Hugging Face, https://huggingface.co/DeepBeepMeep/Wan2.1

- thankfulcarp/wan2gp-docker:runpod-latest, https://hub.docker.com/layers/thankfulcarp/wan2gp-docker/runpod-latest/images/sha256-a15e4c1adc5005f15a145c99dc78bf2f64b9068b8671b060748f03fbc8f077ec

- How to Run Advanced AI Models on Old GPU | Wan2GP Video Generator Guide | RTX 2070 Tested, https://www.youtube.com/watch?v=DQ92CmedQz0&vl=de

- ブログ更新せずに、2年経ったけど・・・, https://nintech.jp/2025/04/10/%E3%83%96%E3%83%AD%E3%82%B0%E6%9B%B4%E6%96%B0%E3%81%9B%E3%81%9A%E3%81%AB%E3%80%812%E5%B9%B4%E7%B5%8C%E3%81%A3%E3%81%9F%E3%81%91%E3%81%A9%E3%83%BB%E3%83%BB%E3%83%BB/

- 【神ツール】低スぺPCでも動画生成ができる「Wan2GP」がすごい!, https://note.com/aicu/n/nc37f872eae43

- Wan2.1 - work4ai, https://scrapbox.io/work4ai/Wan2.1

- FramePack :動画生成AIとその実行手順 on Paperspace Gradient, https://nintech.jp/2025/04/20/framepack-%EF%BC%9A%E5%8B%95%E7%94%BB%E7%94%9F%E6%88%90ai%E3%81%A8%E3%81%9D%E3%81%AE%E5%AE%9F%E8%A3%85%E6%89%8B%E9%A0%86-on-paperspac-gradient/

- SkipLayerGuidance - work4ai, https://scrapbox.io/work4ai/SkipLayerGuidance

- ComfyUI-MochiWrapper - aibase, https://www.aibase.com/ja/tool/33980

- 【Wan2.1】Alibabaが開発した動画生成AIがヤバすぎる, https://m.youtube.com/watch?v=OAdf7b9P5Co

- Going to do a detailed Wan guide post, including how to use LoRAs for facial expressions, style, and motion. Here are some examples of facial expressions. : r/StableDiffusion, https://www.reddit.com/r/StableDiffusion/comments/1j1ijz7/going_to_do_a_detailed_wan_guide_post_including/?tl=ja

- So how do I actually get started with Wan 2.1? : r/StableDiffusion, https://www.reddit.com/r/StableDiffusion/comments/1ji0zr1/so_how_do_i_actually_get_started_with_wan_21/?tl=ja

- NIN-TECH, https://nintech.jp/

- 技術 - NIN-TECH, https://nintech.jp/category/tech/

- 【初心者向け】カラースペースと色域について世界一わかりやすく解説します。, https://www.youtube.com/watch?v=O7GAtPXW10A

- deepbeepmeep (GitHub), https://github.com/deepbeepmeep

- Pinokio | The AI Browser, https://pinokio-home.netlify.app/

- DeepBeepMeep (Hugging Face), https://huggingface.co/DeepBeepMeep

- Best open source model for text to video? : r/StableDiffusion, https://www.reddit.com/r/StableDiffusion/comments/1lbw9e2/best_open_source_model_for_text_to_video/

- Pleasant_Strain_2515 (u/Pleasant_Strain_2515) - Reddit, https://www.reddit.com/user/Pleasant_Strain_2515/

- Runninghub, https://www.runninghub.cn/workflows

- VRAMとは?グラボの重要な役割とメモリ不足の影響を初心者向けに解説, https://www.blooktecpc-support.com/useful/gpu_vram/

- グラフィックボード(グラボ)とは?役割や選び方をわかりやすく解説!, https://www.cfd.co.jp/article/graphics-board/detail/details0001.html

- VRAMとは | パソコン用語集, https://swri.jp/glossary/VRAM

- VRAMとは?ビデオメモリの役割と不足時の影響を初心者向けに解説, https://kick-freedom.com/19191/

- ビデオメモリ(VRAM/GPUメモリ)とは?確認方法・増やし方をご紹介!, https://jp.minitool.com/lib/vram.html

- グラフィックボード(グラボ)とは?役割や選び方、交換方法を解説, https://dosparaplus.com/library/details/000636.html

- Gradioとは?Pythonで機械学習Webアプリケーションを, https://aiacademy.jp/media/?p=3469

- 機械学習向けWeb UIライブラリ Gradio, https://qiita.com/kzkymn/items/901ba79052190e428697

- Gradio入門, https://note.com/npaka/n/nb9d4902f8f4d

- Gradio で生成 AI エージェントを活用したアプリケーションを迅速に構築, https://cloud.google.com/blog/ja/products/ai-machine-learning/rapidly-build-an-application-in-gradio-power-by-a-generative-ai-agent

- Gradioを触ってみる, https://zenn.dev/ohke/articles/9ce51323c44f80

- pythonで機械学習のUIを簡単に実装できるgradio, https://blueqat.com/yuichiro_minato2/a8a5157c-9d79-49f1-b4f9-1e45a9938f8e

- LoRA(ローラ)とは?画像生成AI「Stable Diffusion」で注目, https://jitera.com/ja/insights/41587

- LoRAとは? 画像生成AIのクオリティを上げる追加学習システム, https://www.capa.co.jp/archives/43660

- LoRA(Low-Rank Adaptation)とは?画像生成AI「Stable Diffusion」で注目されるファインチューニングのやり方を解説, https://jitera.com/ja/insights/41587

- 低ランク適応(LoRA)とは何か, https://www.cloudflare.com/ja-jp/learning/ai/what-is-lora/

- LoRAとは?, https://dc-okinawa.com/ailands/ai-glossary-words18/

- LoRAとは?Stable Diffusionの追加学習を手軽にする仕組みを解説, https://ledge.ai/articles/LoRA

- ControlNetとは?Stable Diffusionを変える拡張機能・特徴, https://ai-market.jp/technology/controlnet/

- 【2024】ControlNetとは?Stable Diffusionで使える機能やメリット・導入方法を解説!, https://weel.co.jp/media/controlnet/

- ControlNetとは?Stable Diffusionの画像生成を自由自在に操る新技術を徹底解説, https://ai-market.jp/technology/controlnet/

- ControlNetとは?主要機能や使い方、商用利用について解説, https://www.ai-souken.com/article/what-is-controlnet

- 【Stable Diffusion】ControlNetの全14種類の機能使い方を徹底解説, https://qiita.com/Marusoccer/items/ca682b87003744ddcc37

- 【ControlNet】Stable Diffusionで神絵を生み出す使い方, https://drop4i.com/article/contents/controlnet/

- ファインチューニングとは?RAGとの違いやメリット・デメリットを解説, https://aismiley.co.jp/ai_news/fine-tuning-rag-difference/

- 生成AIのファインチューニングとは?メリット・やり方も紹介, https://metaversesouken.com/ai/generative_ai/fine-tuning-2/

- ファインチューニングとは?仕組みや実施手順をわかりやすく解説, https://www.skygroup.jp/media/article/4090/

- ファインチューニングとは?AIモデルの精度を高める学習方法を解説, https://fastlabel.ai/blog/fine-tuning

- ファインチューニングとは?AI を有効活用するためのポイントを解説, https://g-gen.co.jp/useful/General-tech/explain-fine-tuning/

- ファインチューニングとは?その手法とメリットを解説, https://appen.co.jp/blogs/fine-tuning

コメント