【2025年最新】動画生成AI『Wan2.5』完全ガイド:使い方から料金、SoraやVeoとの比較まで徹底解説のPodcast

下記のPodcastは、Geminiで作成しました。

ストーリーブック

序章:動画生成AIの新たな地平を拓く「Wan2.5」の登場

2025年、人工知能(AI)によるクリエイティブ分野の革新は、留まることを知らない勢いで加速しています。特に動画生成AIの領域では、数ヶ月ごとに業界の常識を覆すような新しいモデルが登場し、競争は激化の一途をたどっています 。このような急速な進化の最前線に、2025年9月頃に正式発表された次世代AI動画モデル「Wan2.5」が躍り出ました 。

Wan2.5の登場が画期的である最大の理由は、従来の動画生成AIが抱えていた根本的な課題、すなわち「音声の欠如」を解決した点にあります。これまでの多くのモデルが生み出す映像は無音であり、クリエイターはAIで動画を生成した後、別途ビデオ編集ソフトを用いて手動で効果音やBGM、ナレーションを追加し、同期させるという時間と専門技術を要する作業を強いられてきました。

Wan2.5はこのワークフローを根底から覆します。テキストや画像から動画を生成する際に、シーンに合わせた環境音、BGM、さらにはセリフまでもが映像と完全に同期した状態で一度に出力されるのです 。この「ワンパス」での視聴覚コンテンツ生成は、単なる機能追加ではありません。それは、動画生成AIを単なる「視覚効果ツール」から、アイデアの着想から完成までを担う「エンドツーエンドのコンテンツ制作プラットフォーム」へと昇華させるパラダイムシフトを意味します。これにより、高度な編集スキルを持たない個人や小規模なチームでも、プロ品質の動画コンテンツを迅速かつ容易に制作できるようになり、動画制作の民主化が新たな段階へと進むことになります。

Wan2.5とは?新世代モデルの正体と開発背景

この革新的なAIモデル「Wan2.5」を開発したのは、中国のテクノロジー大手であるアリババ(Alibaba)です。Wan2.5は、同社が開発する大規模言語モデル「Qwen」シリーズの技術基盤の上に構築されており、非常に評価の高かったオープンソースモデル「Wan2.1」や「Wan2.2」の正統な後継機にあたります 。このモデルの進化の系譜は、強力なオープンソース基盤の構築から、MoE(Mixture-of-Experts)アーキテクチャのような先進技術の導入、そして今回のネイティブ音声生成機能の実装へと、着実な技術的進歩を示しています。

ここで重要な点を明確にしておく必要があります。Pollo AI、Fotor、Runcomfyといったサービスは、Wan2.5の開発元ではありません 。これらは、アリババが提供するWanモデルのAPI(Application Programming Interface)を自社のプラットフォームに統合し、ユーザーが直感的に利用できるインターフェースを提供しているサードパーティのサービス事業者です 。ユーザーは、これらのサービスを通じて、アリババの最先端技術を手軽に利用することができるのです。

また、一部で見られる「AnkerMake Wan2.5」という表現は誤解に基づいています。AnkerMakeは3Dプリンターのブランドであり、アリババのAIモデルとは一切関係ありません 。

アリババの戦略は、OpenAIの「Sora」やGoogleの「Veo」といった欧米の巨大テック企業が採用するクローズドなアプローチとは一線を画します。彼らは、Wan2.1やWan2.2といった高性能モデルをオープンソースとして公開することで、開発者やクリエイターの巨大なコミュニティを育成し、自社技術への信頼と支持を築き上げました 。この強固な基盤の上に、最先端のプレミアムモデルであるWan2.5をAPI経由の商用サービスとして提供することで、自らが育てたコミュニティから即座に需要を創出するという、巧みなハイブリッド戦略を展開しています。これは、オープンソースの理念を尊重しつつ、研究開発の成果を収益化するための非常に洗練されたアプローチと言えるでしょう。

Wan2.5の革新的な機能:単なる動画生成を超えた能力

Wan2.5は、その多岐にわたる機能によって、競合モデルとの差別化を図っています。ここでは、その中でも特に革新的とされる4つの主要機能について詳述します。

ネイティブ音声生成とオーディオ参照:無音AI動画の時代の終わり

Wan2.5の最も革命的な機能は、映像と音声の統合生成能力です。プロンプトに基づいて、セリフ、環境音、BGMなどを映像と完全に同期させた状態で生成できます 。しかし、その真価はさらに先にあります。ユーザーが自身の音声ファイル(ナレーション、効果音、楽曲など)をアップロードし、それを直接的な参照情報(リファレンス)として動画生成に利用できる点です 。これにより、完璧なリップシンク(口の動きと音声の一致)や、意図した通りのタイミングでの音響効果が実現可能になります。このオーディオ参照機能は、GoogleのVeo 3など主要な競合モデルには見られない、決定的な優位性となっています 。

高解像度・長時間生成:1080pで最大10秒の表現力

品質面においても、Wan2.5は高い水準を誇ります。動画は映画制作の標準である毎秒24フレーム(24fps)で、最大1080pのフルHD解像度で生成されます。一部のプラットフォームでは、将来的な4K解像度への対応も示唆されています 。また、1回の生成で最大10秒間のクリップを作成でき、これはGoogle Veo 3の約8秒という制限よりも長く、より豊かな物語性や複雑なアクションを表現する上で有利に働きます 。

シネマティック・コントロール:誰でも映画監督になれる

Wan2.5は、ユーザーを単なる「プロンプト入力者」から、主体的な「AIディレクター」へと変貌させます。テキストプロンプトを通じて、カメラワーク(パン、チルト、ドリー、ズーム、トラッキングショットなど)、照明(ゴールデンアワー、スタジオ照明など)、構図といった、映画制作における専門的な要素を細かく指示することが可能です 。これにより、クリエイターは自らの創造的なビジョンを、より忠実に、そしてダイナミックに映像化することができます。実際に、映画のような複雑な指示を含んだプロンプトが見事に解釈され、高品質な映像として出力された多数の事例が報告されています 。

リアリズムと一貫性の向上

AIによる動画生成で課題となりがちな、物理法則の不自然さや映像のちらつき(フリッカー)といった問題に対し、Wan2.5は大幅な改善を実現しています。現実世界の物理法則をより正確にシミュレートすることで、人物や物体の動きが自然で滑らかになりました 。また、フレーム間での登場人物や背景の一貫性が向上し、映像全体の安定感と没入感が高まっています 。

これらの機能、特にオーディオ参照とシネマティック・コントロールの組み合わせは、新たなクリエイティブスキルセットの誕生を予感させます。それは「AI駆動型マルチモーダル・ディレクション」とでも言うべきものです。クリエイターは、単に情景を描写するだけでなく、視覚的な脚本(カメラ指示を含むプロンプト)と聴覚的な脚本(アップロードした音声ファイル)からなる完全な設計図をAIに提供します。AIの役割は、漠然としたアイデアから何かを生み出す「生成者」から、詳細なクリエイティブブリーフを忠実に実行する「遂行者」へと変化します。これにより、AIコンテンツ制作は、偶然性に頼る「プロンプトガチャ」から、制作者の明確なビジョンと演出能力が問われる、より専門的な領域へと進化していくでしょう。

競合モデルと徹底比較:Wan2.5はSora、Veo 3、Klingとどう違うのか?

動画生成AI市場には、それぞれ異なる強みを持つ有力なモデルが存在します。Wan2.5がこの競争環境の中でどのような位置づけにあるのかを、主要な競合モデルであるGoogleの「Veo 3」、OpenAIの「Sora」、そしてKuaishouの「Kling」と比較しながら明らかにします。

- 対 Google Veo 3: Wan2.5は、より手頃な価格設定、より長い生成時間(10秒対8秒)、そして決定的な違いとして外部音声のアップロードに対応している点で優位に立っています 。

- 対 OpenAI Sora: Soraは最大60秒という長尺の動画生成能力や、驚異的な一貫性で注目を集めましたが、一般公開がされておらず、生成される動画は無音です。対照的に、Wan2.5は多くのプラットフォームで既に利用可能であり、音声という実用的な課題を解決しています 。

- 対 Kuaishou Kling: Klingもアリババと同じく中国のテック企業が開発した非常に強力なモデルで、高い映像品質を誇ります。しかし、Wan2.5が持つオープンソースの伝統と、独自のオーディオ参照機能は、明確な差別化要因となっています 。

結論として、Wan2.5は「視聴覚の統合」と「アクセシビリティ」という2つの軸で、競合に対して強力なポジションを築いています。特に、外部音声を扱える唯一の主要モデルである点は、実用的なコンテンツ制作において計り知れない価値を持ちます。

初心者のためのWan2.5利用ガイド

Wan2.5の利用開始は非常に簡単です。ここでは、初めて利用するユーザー向けに、プラットフォームの選択から料金体系の理解までを分かりやすく解説します。

どこで使える?Wan2.5が利用可能なプラットフォーム

Wan2.5は、開発元であるアリババが提供する公式サイト「wan.video」で利用できるほか、APIを介して様々なサードパーティのプラットフォームでも利用が可能です 。代表的なサービスには以下のようなものがあります。

- wan.video

- Pollo AI

- Fotor

- Runcomfy

- Higgsfield AI

- Vadoo AI

- GoEnhance AI

- Wavespeed.ai

これらのプラットフォームの多くは、新規登録時に無料のトライアルクレジットを提供しているため、費用をかけずにWan2.5の性能を試すことが可能です 。

ステップ・バイ・ステップ:初めての動画作成

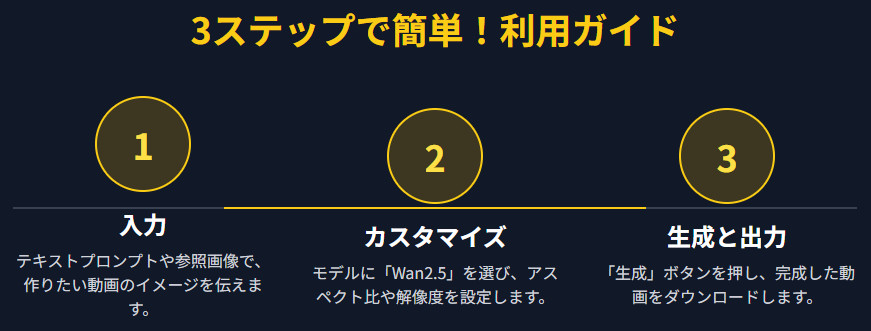

どのプラットフォームでも、基本的な動画作成のプロセスは共通しており、以下の3つの簡単なステップで完了します 。

- 入力 (Input): 作成したい動画の内容を説明するテキストプロンプトを入力します。または、動画のベースとなる参照画像をアップロードすることもできます。

- カスタマイズ (Customize): 利用するAIモデルとして「Wan2.5」を選択します。その後、動画のアスペクト比(16:9、9:16など)や解像度(720p、1080pなど)を設定します。

- 生成と出力 (Generate & Export): 「生成」ボタンをクリックすると、数分で動画が作成されます。完成した動画をプレビューで確認し、満足のいく出来であればダウンロードします。

料金体系を理解する

Wan2.5を利用するための料金体系は、プラットフォームによって異なりますが、主に2つの形式が採用されています。

- 月額サブスクリプションプラン: 毎月一定額を支払うことで、決まった量のクレジットが付与されるプランです。「スターター」「プロ」「エンタープライズ」のように、料金に応じてクレジット数や利用可能な機能が異なります。

- 都度購入のクレジットパッケージ: サブスクリプションに登録せず、必要な分だけクレジットを一度に購入する形式です。

例えば、wan2-1.comというプラットフォームでは、「スタータープラン」が月額34.9で200クレジットといったプランが提供されています 。生成する動画の解像度や長さによって消費クレジット数が変動するため、自身の利用頻度に合わせて最適なプランを選択することが重要です。

プロンプトの極意:魅惑的な動画を生み出すためのヒントと作例

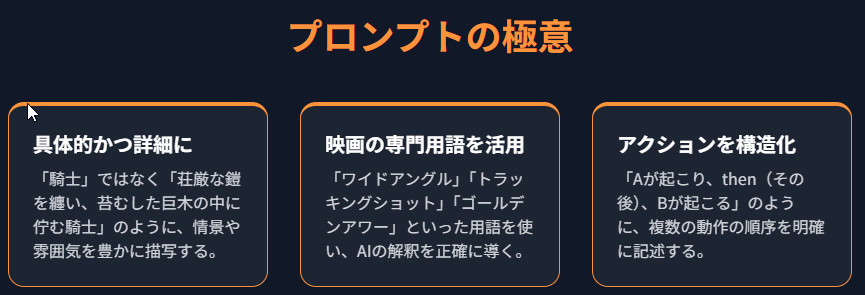

Wan2.5のポテンシャルを最大限に引き出す鍵は、プロンプト(指示文)の質にあります。ここでは、高品質な動画を生成するための具体的なヒントと作例を紹介します。

- 具体的かつ詳細に記述する: 「一人の騎士」と書くのではなく、「苔むした巨木の中に佇む、荘厳な鎧を纏った騎士。その手は剣の柄に置かれている」のように、情景、登場人物、服装、雰囲気などを豊かに描写することが重要です 。

- 映画制作の専門用語を活用する: AIは映画制作に関する膨大なデータを学習しています。「ワイドアングル(広角)」「スローリー・ムーブズ・クローサー(ゆっくりと接近)」「トラッキングショット(移動撮影)」「ゴールデンアワー(日の出後・日没前の時間帯)」「ネオンサインが明滅する」といった専門用語をプロンプトに含めることで、AIの解釈をより正確に導き、意図した通りの映像表現を得やすくなります 。

- 連続するアクションを構造化する: 複数の動作を順番に行わせたい場合は、「Aが起こり、then(その後)、Bが起こる」のように、アクションの順序を明確に記述すると効果的です 。

【プロンプト作例】

以下は、実際に高品質な動画を生成したプロンプトの例です 。wan.video では、無料の場合10クレジットしかもらえず、作例を試そうとしましたが時間が長くかかり上手く作成してくれませんでした。

作例1:サイバーパンク・アニメ Japanese anime style with a cyberpunk aesthetic. A lone figure in a hooded jacket stands on a rain-soaked street at night, neon signs flickering in pink, blue, and green above. The camera tracks slowly from behind as the character walks forward... (サイバーパンクの美学を持つ日本のアニメスタイル。フード付きジャケットを着た孤独な人物が、夜の雨に濡れた通りに立っている。頭上ではピンク、青、緑のネオンサインが明滅している。キャラクターが前進するにつれて、カメラは背後からゆっくりと追跡する...)

作例2:F1レース A cinematic tracking shot of a Ferrari Formula 1 car racing through the iconic Monaco Grand Prix circuit. The camera is fixed on the side of the car that is moving at high speed, capturing the sleek red bodywork glistening under the Mediterranean sun... (象徴的なモナコGPサーキットを疾走するフェラーリF1カーの映画的なトラッキングショット。カメラは高速で移動する車の側面に固定され、地中海の太陽の下で輝く滑らかな赤いボディを捉えている...)

これらのプロンプトは、スタイル、キャラクター、アクション、カメラワーク、照明といった要素を網羅的に記述することで、AIに対して明確なビジョンを伝えています。

Wan2.5の技術的背景と今後の展望

Wan2.5の驚異的な性能は、最先端のAI技術によって支えられています。その中核をなすのが「Diffusion Transformer」というアーキテクチャです 。これは、ノイズだらけのキャンバスに少しずつ情報を加えていき、最終的に鮮明な画像を浮かび上がらせる画家に例えることができます。このプロセスを動画の各フレームに対して適用することで、滑らかで一貫性のある映像を生成します。

さらに、Wanモデル群の根幹には「MoE(Mixture-of-Experts)」という効率的な設計思想があります 。これは、一つの巨大なAIが全ての処理を行うのではなく、AI内部に複数の「専門家(エキスパート)」チームを置き、タスクに応じて最適な専門家を割り当てる仕組みです。例えば、「動画全体の構図を考える専門家」と「細部の質感を仕上げる専門家」が連携することで、より高品質な結果を効率的に生み出すことができます。

今後の展望として、Wan2.5は現在「プレビュー版」として提供されており、開発者コミュニティは、前身モデルの慣例に従い、将来的に完全なオープンソース版がリリースされることを強く期待しています 。ただし、現在のモデルを個人のPCで動作させるには膨大な計算資源(VRAM)が必要であり、多くのユーザーにとっては当面の間、API経由での利用が現実的な選択肢であり続けるでしょう 。

結論:なぜWan2.5は全てのクリエイターが注目すべきAIなのか

Wan2.5は、単なる新しい動画生成ツールではありません。それは、クリエイティブな表現のあり方を根底から変える可能性を秘めた、触媒のような存在です。その重要性は、以下の4つの点に集約されます。

- 視聴覚のシナジー: 無音動画の時代に終止符を打ち、映像と音声を統合することで、コンテンツ制作の実用性を飛躍的に高めました。

- クリエイティブな制御: 映画監督レベルの緻密なコントロールを可能にし、クリエイターの創造性を最大限に解放します。

- 優れたアクセス性: 多くのプラットフォームを通じて広く利用可能であり、競合モデルと比較して手頃な価格設定がなされています。

- 戦略的な市場ポジショニング: オープンソースと商用サービスを組み合わせた独自の戦略により、世界のAI開発競争において極めて強力なプレイヤーとなっています。

Wan2.5の登場によって、プロの映像作家から、マーケター、教育者、そしてSNSで自己表現を楽しむ個人まで、あらゆる人々が、かつては想像もできなかったような高品質な視聴覚コンテンツを、手軽に生み出せるようになります。これは、誰が物語を語り、どのように語るのかという、ストーリーテリングの根源的なあり方を変革する、大きな一歩と言えるでしょう。

参考資料

- Pollo AI、新AI動画モデル「Vidu Q2」「Kling 2.5 Turbo」をリリース, https://prtimes.jp/main/html/rd/p/000000044.000131648.html

- AlibabaのWan 2.5 AI動画生成モデルで、音声とリップシンクが完璧に同期した長時間動画を簡単作成。, https://www.fotor.com/jp/ai-video-generator/wan/

- 【最新】動画生成AI『Wan2.5』がヤバい。BO3を超えたと話題に!,(https://www.youtube.com/watch?v=T9I-qpfW7ro)

- 【最新】動画生成AI「Wan2.5」がc-artでも使えるように!使い方と性能を解説, https://www.youtube.com/watch?v=lzc-QdHz_dg

- 【神】遂にあの動画生成AIが無料で使い放題へ!最新の「Wan2.5」も対象に!, https://www.youtube.com/watch?v=fcL7N4kuqNA

- Wan 2.5 AI Video Generator, https://www.imagine.art/features/wan-2-5

- Wan AI: Leading AI Video Generation Model, https://wan.video/

- Wan 2.5 Preview is Ready, https://wan2-1.com/

- Wan-AI/Wan2.2-S2V-14B,((https://huggingface.co/Wan-AI/Wan2.2-S2V-14B))

- Wan 2.5: Text/Image to Video Model, https://www.runcomfy.com/playground/wan-ai/wan-2-5

- Wan 2.5 is really, really good. Native audio., https://www.reddit.com/r/comfyui/comments/1nutwxv/wan_25_is_really_really_good_native_audio/

- WAN2.5-Preview: They are collecting feedback to fine-tune this PREVIEW.,((https://www.reddit.com/r/StableDiffusion/comments/1nqhycy/wan25preview_they_are_collecting_feedback_to/))

- Wan2. 5-Preview Release: Achieving Multimodal Input and Cinematic-Grade Video Synchronization Generation, https://www.aibase.com/news/21531

- Wan-AI/Wan2.2-TI2V-5B,((https://huggingface.co/Wan-AI/Wan2.2-TI2V-5B))

- [2503.20314] Wan: Open and Advanced Large-Scale Video Generative Models, https://arxiv.org/abs/2503.20314

- [2412.15115] Qwen2. 5 Technical Report, https://arxiv.org/abs/2412.15115

- Wan 2.2 vs OpenAI's Sora - The Clear Winner, https://www.reddit.com/r/comfyui/comments/1nn0thw/wan_22_vs_openais_sora_the_clear_winner/

- Does anyone else feel like their workflows are far inferior to Sora 2?, https://www.reddit.com/r/comfyui/comments/1nwj51d/does_anyone_else_feel_like_their_workflows_are/

- Sora Vs. Kling - First 5 sec is Sora, the final 10 sec is Kling. Kling is obviously better.,(https://www.reddit.com/r/SoraAi/comments/1hd2oji/sora_vs_kling_first_5_sec_is_sora_the_final_10/)

- Head-to-head comparison of 8 img2vid models. Who wins?, https://www.reddit.com/r/aivideo/comments/1j2wblt/headtohead_comparison_of_8_img2vid_models_who/

- Wan 2.1: The FREE AI Video Generator That Rivals Sora & Veo!, https://www.youtube.com/watch?v=FHbrUAnVl2Q

- Top 5 AI Video Generation Models Compared: Hunyuan, Kling, Wan, MiniMax & Sora, https://blogs.novita.ai/top-5-ai-video-models/

- WAN 2.5 AI Video Generator - Native 4K Text-to-Video, https://www.fluxpro.ai/vm/wan/wan-2-5

- WAN 2.5: Next-Level AI Video Generation Preview, https://www.vadoo.tv/wan-2-5-ai-video-generator

- Wan 2.5 AI Video Generator, https://www.goenhance.ai/video-models/wan-2-5

- Wan 2.5 AI動画生成モデル, https://www.fotor.com/ai-video-generator/wan/

- Wan 2.5 vs Google Veo 3 which one is best AI Video Generator,((https://www.youtube.com/watch?v=pjAS0OIKtuU))

- I Tried EVERY AI Video Generator (Here's What Each Does Best), https://www.youtube.com/watch?v=tLagFJ7lA6Q

- AnkerMake M5 3D Printer, https://www.eufymake.com/eu-en/m5

- WAN2.5-Preview,(https://www.reddit.com/r/StableDiffusion/comments/1np0v5n/wan25preview/)

- Wan 2.5,(https://www.reddit.com/r/StableDiffusion/comments/1noc2d9/wan_25/)

- EufyMake M5 3D Printer, https://www.eufymake.com/products/m5

- AnkerMake M5 3D Printer FAQ,((https://support.ankermake.com/s/article/AnkerMake-M5-3D-Printer-FAQ-1))

- AnkerMake M5 - 5X Faster 3D Printing,((https://www.youtube.com/watch?v=1R14iuPkNAA))

- ファーウェイ、アリババのオープンソースAIモデルを盗用したとして告発される, https://www.webull.co.jp/news-detail/13119422574126080

- Wan AI動画ジェネレーター(Wan 2.1), https://pollo.ai/ja/m/wanx-ai

- Pollo AI: AI Video & Art Maker, https://play.google.com/store/apps/details?id=ai.pollo.ai

- Wan 2.2 AI Video Generator, https://pollo.ai/m/wanx-ai/wan-2-2

- Wan AI Video Generator (Wan 2.1), https://pollo.ai/m/wanx-ai

- Alibaba makes AI video generation model free to use globally, https://www.reddit.com/r/OpenAI/comments/1iyko9w/alibaba_makes_ai_video_generation_model_free_to/

- Wan 2.2 – Alibaba's Latest Open-Source AI Video Generator, https://www.vadoo.tv/wan-2-2

- Wan 2.5 Free: Try This Wan AI Video Model Now, https://pollo.ai/m/wanx-ai/wan-2-5

- [2503.20314] Wan: Open and Advanced Large-Scale Video Generative Models, https://arxiv.org/abs/2503.20314

- Wan: Open and Advanced Large-Scale Video Generative Models,((https://www.researchgate.net/publication/390991684_Wan_Open_and_Advanced_Large-Scale_Video_Generative_Models))

- Wan: Open and Advanced Large-Scale Video Generative Models, https://www.themoonlight.io/en/review/wan-open-and-advanced-large-scale-video-generative-models

- Wan: Open and Advanced Large-Scale Video Generative Models, https://www.youtube.com/watch?v=halyJs5uhxM

- Wan-Video/Wan2.2,((https://github.com/Wan-Video/Wan2.2))

- Wan-Video/Wan2.1,((https://github.com/Wan-Video/Wan2.1))

- Anime with Wan I2V: comparison of prompt formats,((https://www.reddit.com/r/StableDiffusion/comments/1jalber/anime_with_wan_i2v_comparison_of_prompt_formats/))

- WAN2.5-Preview,((https://www.reddit.com/r/StableDiffusion/comments/1np0v5n/wan25preview/))

- Wan VACE T2V accept time with actions in the prompt,((https://www.reddit.com/r/StableDiffusion/comments/1m0midf/wan_vace_t2v_accept_time_with_actions_in_the/))

- Wan 2.2 Animate Character Replacement Test,((https://www.reddit.com/r/StableDiffusion/comments/1nvvo7g/wan_22_animate_character_replacement_test/))

- Wan2.2 Animate Demo,((https://www.reddit.com/r/StableDiffusion/comments/1nxyw4o/wan22_animate_demo/))

- Wan S2V talking examples,((https://www.reddit.com/r/StableDiffusion/comments/1n41la2/wan_s2v_talking_examples/))

コメント